咨询电话: 020-88888888

-

Adam优化算法(Adam optimization algorithm)_1

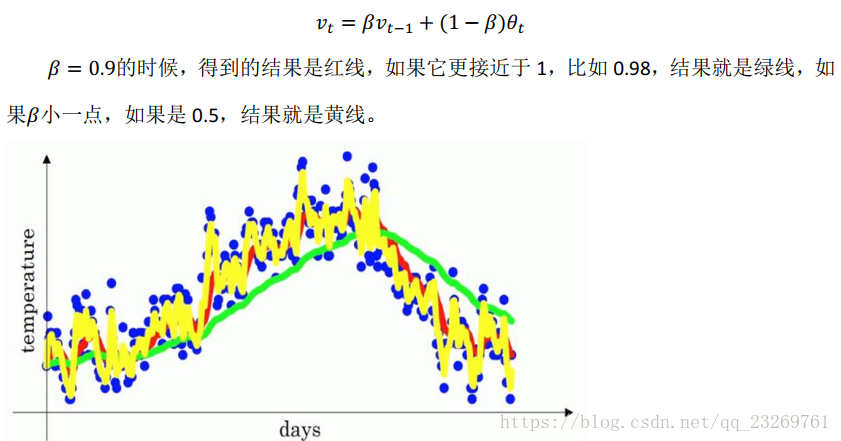

Adam优化算法(Adamoptimizationalgorithm)Adam优化算法基本上就是将Momentum和RMSprop结合在一起。初始化2.在第t次迭代中,用mini-batch梯度下降法计算出dw和db3.计算Momentum指数加权平均数4.用RMS...

2024-05-06 阅读(74) 标签:算法 优化 me 梯度 我们 -

机器学习—优化器与正则化

在介绍各类优化器之前,我们先来看一下经典的优化算法。经典的优化算法可以分为直接法和迭代法两大类。直接法就是直接对损失函数求导找出损失函数的全局最小值,但是这种方法具有两个局限性,首先损失函数必须是凸函数,其次损失函数倒数等于0的时候必须有闭式解,比如求解线性回归时,涉及到的矩阵的逆,可有些时候矩阵...

2024-04-22 阅读(91) 标签:梯度 函数 学习 -

深度学习总结(一)各种优化算法

参考博文:码农王小呆:深度学习最全优化方法总结:超级详细每个算法的讲解,可参考:1.批量梯度下降(Batchgradientdescent,BGD)θ=θ?ηθJ(θ)每迭代一步,都要用到训练集的所有数据,每次计算出来的梯度求平均η代表学习率LR2.随机梯度下降(Stochastic...

2024-04-15 阅读(74) 标签:梯度 学习 -

Pytorch——可视化不同的优化器效果

使用简单功能可视化梯度优化器目的梯度下降是我们用于机器学习的优化的基本原理之一。但是,希望了解更多有关该领域的初学者会遇到通用图或仅与抽象意义相关的等高线图。像这样的图形可以初步了解什么是梯度下降及其作用,但是比有趣的图片还缺乏深度。大多数机器学习模型的高维性使得初学者很难形象化。本笔记本的目的是提...

2024-03-12 阅读(155) 标签:优化 笔记本 梯度 可以 下降 -

优化器调整策略

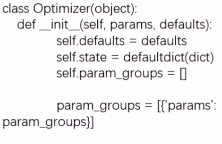

损失函数的作用是衡量模型输出与真实标签的差异。当我们有了这个loss之后,我们就可以通过反向传播机制得到参数的梯度,那么我们如何利用这个梯度进行更新参数使得模型的loss逐渐的降低呢?优化器的作用Pytorch的优化器:并模型中可学习参数的值,使得模型输出更接近真实标签。Optimizer的基本属性...

2024-03-04 阅读(151) 标签:参数 梯度

新闻资讯

-

强化业绩补偿监管,支持环保企业 05-15

-

利率大幅单边上行可能性不大 05-15

-

商标注册申请的基本流程有哪些? 05-30

-

商标注册的八大作用 05-11

-

优化创新,optimizati 05-13

-

房地产营销策划方案_1 05-13

-

抖音直播历史记录怎么查看 05-13

-

【PPT】分布式光伏设计、建设 05-13